Facebook母公司meta取消了其“科学知识”人工智能模型的公开演示,因为学者们发现,该模型在过滤整个研究类别的同时,产生了虚假和误导性的信息。

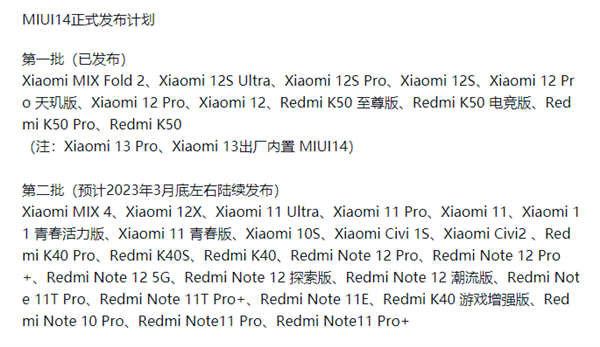

本周早些时候发布的该公司称,卡拉狄加是一个人工智能语言模型,“可以存储、组合和推理科学知识”,包括总结研究论文、解方程和执行一系列其他有用的科学任务。但科学家和学者很快发现,人工智能系统的摘要正在产生数量惊人的错误信息,包括引用真实作者的研究论文,而这些作者并不存在。

“在所有情况下,它都是错误或有偏见的,但听起来是正确和权威的,”马克斯·普朗克智能系统研究所(Max Planck Institute for Intelligent Systems)所长迈克尔·布莱克(Michael Black)在使用该工具后在Twitter的一个帖子中写道。“我认为这很危险。”

布莱克的思路抓住了卡拉狄加产生的科学文本具有误导性或完全错误的各种情况。在几个例子中,人工智能生成的文章听起来权威且可信,但没有实际科学研究的支持。在某些情况下,引用甚至包括真正作者的名字,但链接到不存在的Github仓库和研究论文。

其他人指出,卡拉狄加没有返回广泛的研究主题的结果,可能是因为人工智能的自动过滤器。华盛顿大学(Washington University)的计算机科学研究员威利·阿格纽(Willie Agnew)指出,“酷儿理论”、“种族主义”和“艾滋病”等查询都没有返回结果。

周四早上,梅塔删掉了卡拉狄加的演示。当记者联系到该公司置评时,该公司让Motherboard参考它通过负责该系统的项目Papers With Code发布的一份声明。

该公司在Twitter上写道:“我们感谢到目前为止从社区收到的反馈,目前暂停了演示。”“我们的模型可供想要更多了解这项工作并在论文中再现结果的研究人员使用。”

一些meta员工也加入了讨论,暗示演示版本被删除是对批评的回应。

meta的首席人工智能科学家扬·勒昆(Yann LeCun)在推特上写道:“卡拉狄加演示版本暂时下线。”“通过随意滥用它来获得乐趣已经不可能了。开心呢?”

这并不是Facebook第一次在发布了一款带有严重偏见的人工智能后,不得不做出解释。今年8月,该公司发布了一款名为BlenderBot的聊天机器人的演示版本,该机器人在进行奇怪而不自然的对话时,会发表“冒犯性和不真实的”言论。该公司还发布了一个名为OPT-175B的大型语言模型,研究人员承认它具有种族主义和偏见的“高倾向”——很像类似的系统,如OpenAI的GPT-3。

卡拉狄加也是一个大型语言模型,这是一种机器学习模型,以生成非常可信的文本而闻名,感觉像是人类写的。虽然这些系统的结果通常令人印象深刻,但卡拉狄加是另一个例子,说明了产生可信的人类语言的能力并不意味着系统真正理解其内容。一些研究人员质疑大型语言模型是否应该被用来做任何决策,他们指出,大型语言模型令人麻木的复杂性使科学家几乎不可能审核它们,甚至无法解释它们是如何工作的。

这显然是一个严重的问题,特别是在科学研究方面。科学论文基于严格的方法论,而文本生成的人工智能系统显然无法理解——至少目前还不能。布莱克担心发布卡拉狄加这样的系统的后果是可以理解的,他说,这“可能会开启一个深度科学造假的时代。”

“它提供了听起来权威的科学,但没有科学方法的基础,”布莱克在推特帖子中写道。“它根据科学写作的统计特性制造伪科学。语法科学写作和科学研究不一样。但很难区分。”